Actualités

Ecosystème

Emploi

environnement

Evénement

Facture Electronique

innovation

Numérique

offre

Partenariat

Sinapps IRD

Solution

Suite Assuré

Evénement

DARVA vous donne rendez-vous à Equip Auto

Parc des Expositions de Versailles, du 14 au 18 octobre 2025

Sinapps IRD

Suite Assuré

Interview : BPCE est le premier assureur à se lancer sur la Suite Assuré

Témoignage client : BPCE Assurances est le premier assureur à activer le nouveau module Suite Assuré de Sinapps IRD

Sinapps IRD

Un nouvel assureur déploie Sinapps IRD

Retour sur le démarrage Sinapps IRD réussi pour le Groupe MACSF.

Sinapps IRD

Sinapps IRD, version Summer 25

Découvrez les nouvelles fonctionnalités et les évolutions du Module “Suite Assuré”

Evénement

Sur la route des grands événements Auto !

Congrès A+GLASS - Journée MACIF de la Réparation Auto - Salon des Partenaires CESVI France

Sinapps IRD

Nouveaux clients en IRD pour les processus de réparation en nature et de recherche de fuite

Groupama, Gan Assurances, Mutuaide FMB déploient de nouveaux processus.

Sinapps IRD

Sinapps IRD, version Spring 25 : nouvelles fonctionnalités & évolution du Module “Suite Assuré”

Cette version Spring 25 de Sinapps IRD, s’enrichit de nouvelles fonctionnalités, d'abord, avec le module “Suite Assuré” complété par le processus « Réparation en nature ».

Sinapps IRD

Sinapps IRD, version WINTER 24 : découvrez les nouvelles fonctionnalités et la Suite Assuré

Nous vous dévoilons dans cette actu’ les dernières nouveautés de Sinapps IRD, édition WINTER 24, disponibles dès le 04 décembre.

Facture Electronique

DARVA officiellement immatriculée comme Plateforme de Dématérialisation Partenaire avec Ofeli

Facture Electronique : Ofeli officiellement immatriculée Plateforme de Dématérialisation Partenaire

Sinapps IRD

Nouveautés Sinapps IRD - Version FALL 2024 : zoom sur les principales fonctionnalités

Nous vous dévoilons dans cette actu’ les dernières nouveautés de Sinapps IRD, édition FALL 2024, disponibles dès le 04 septembre.

Ecosystème

environnement

innovation

DARVA et le Parc naturel régional du Marais poitevin s'associent pour créer un Observatoire du climat

Au cœur de leur partenariat de 5 années : la mise en place d'un Observatoire du climat pour comprendre les effets du changement climatique.

innovation

Solution

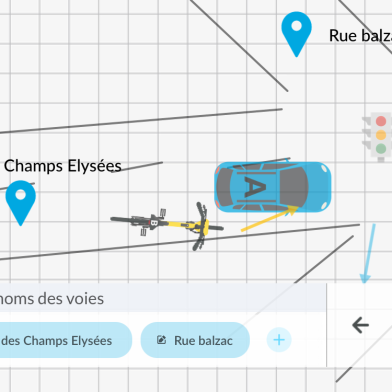

Sinapps Auto Omega : Votre nouvel allié dans la gestion des EGA

Sinapps Auto Omega est votre nouveau module d'aide à la gestion des Episodes de Grande Ampleur (EGA) ! Gagnez en efficacité et en souplesse grâce à DARVA !

Ecosystème

Numérique

DARVA membre de la Fédération Nationale des Tiers de Confiance du numérique

Avec plus de 160 membres, la FnTC est l'une des organisations les plus influentes dans le domaine du numérique en France.

Sinapps IRD

La Summer Edition 2024 de Sinapps IRD est disponible

Toutes les nouveautés fonctionnelles de Sinapps IRD

Sinapps IRD

AXA et les grands réseaux d’expertise démarrent sur le module de prise de rendez-vous

AXA, acteur majeur de l'assurance, démarre sur le module de prise de rendez-vous de DARVA en IRD

Ecosystème

DARVA & Vous - Sinapps Auto Tour

Réparateurs, Experts, Recycleurs, professionnels de l'automobile, venez nous rencontrer à l'occasion de salons professionnels dans toute la France !

innovation

offre

Solution

La fin de la vignette verte sur le pare-brise ? Tout a été dit ou presque sur le sujet !

La fin de la vignette verte d'assurance sur le pare-brise de votre voiture : on vous a presque tout dit sur le sujet !

Réforme de la Facture Électronique : découvrez les dernières informations de la DGFiP

Réforme de la Facturation Electronique, les dates clés et informations de la DGFiP à retenir.

innovation

Solution

Sinapps Auto Décisions est désormais disponible pour les experts auto !

Découvrez le nouveau service DARVA de pilotage décisionnel à destination des experts automobiles

Facture Électronique : Phase Pilote et Enjeux

La course à la facturation électronique est lancée pour la phase pilote PDP.

Présentations clients : OFELI, l'outil de facturation électronique de DARVA

Matinales OFELI à Paris et à Chauray

Emploi

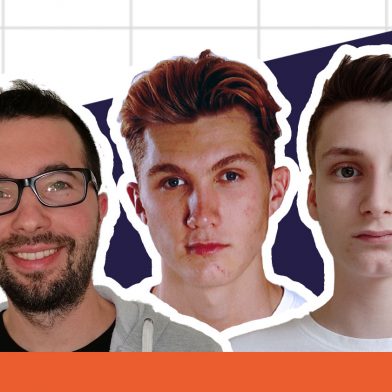

Être stagiaire chez DARVA en 2021, ça donne quoi ?

Nous avons posé quelques questions à 5 de nos stagiaires !